Monica Consolandi, dottorato in filosofia con specializzazione in bioetica e filosofia del linguaggio e oggi ricercatrice presso il Centro Digital Health and Wellbeing – Intelligent Digital Agents Unit della Fondazione Bruno Kessler, sta lavorando su tre progetti di ricerca che mirano a identificare i misunderstanding nella comunicazione medico-paziente attraverso strumenti di filosofia del linguaggio. Scopo dei progetti: mettere a punto strumenti per il training di sistemi di Intelligenza artificiale, «per poterli così istruire sulla base di un apparato teorico solido e con dati reali, naturalmente anonimi».

I suoi campi di riflessione spaziano in uno degli scenari di frontiera più affascinanti (e più delicati) del presente: quanto e come la progressiva integrazione delle tecnologie di intelligenza artificiale in ambito sanitario modificherà non solo i processi, ma anche le riflessioni sui grandi temi etici strettamente connessi al campo della cura.

«Ci sono già diversi esempi efficaci di applicazioni dell’IA a supporto delle équipe di cura»

spiega Consolandi: «Stando all’ambito più vicino alla mia attuale ricerca, le tecnologie di Large Language Model danno risultati interessanti nella fase di anamnesi, con soluzioni di sistemi cosiddetti di speech recognition: l’IA coglie, trascrive e riorganizza le informazioni che vengono scambiate durante il dialogo medico-paziente, rendendo più fluido il momento di confronto, liberando il colloquio dai momenti in cui viene interrotto e spezzato dalle pause in cui il medico digita sulla tastiera, prende appunti, compila un modulo, creando quei silenzi che aumentano il livello di stress emotivo. Altro campo di applicazione interessantissimo, per il quale le soluzioni sono ormai molto avanzate, è quello della diagnostica, con sistemi di IA che “leggono” radiografie, tac, risonanze e altri esami strumentali con una precisione superiore a quanto può fare l’occhio umano, riducendo i margini di errore e attingendo a un enorme database di casistiche».

Si tratta di due casi, concreti e semplici, di come questa tecnologia rappresenti un valore aggiunto. Già a questo livello, però, emerge una problematica, legata alla responsabilità: se nello svolgimento di un compito semplice come la lettura di una radiografia, l’IA commette un errore, chi ne risponde? Il medico che ha impiegato l’IA? La struttura? Nessuno?

«È un tema aperto», dice Consolandi. «Come in svariati altri ambiti di impiego dell’IA, anche nelle applicazioni al campo della cura la tecnologia viaggia molto più veloce rispetto agli iter di regolamentazione, e non può che essere così».

La distanza tra ciò che la tecnologia può già fare, e quanto sia consentito dalle norme esistenti si misura, a maggior ragione, quando si entra nello scenario più avanzato e delicato di applicazione dell’AI predittiva, «con sperimentazioni anche in contesti di cure palliative», dice la ricercatrice.

«In base alla storia clinica di un paziente, l’IA può sviluppare indicazioni previsionali sulla parabola di malattia, le possibili evoluzioni, fino a predire le aspettative di vita più probabili. Questo può dare indicazioni su come garantire la miglior qualità di vita al paziente, sull’appropriatezza delle cure e l’opportunità di evitare accanimento terapeutico, e anche su come gestire le risorse del sistema sanitario».

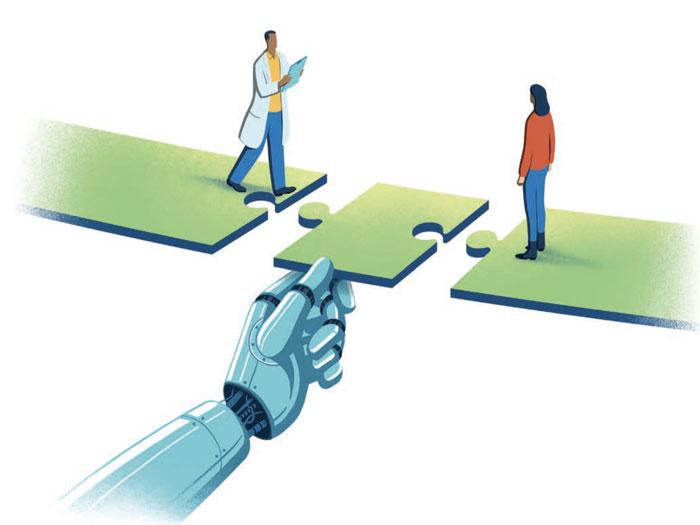

Senza dubbio, immaginare che sia un algoritmo a dirci quanti giorni abbiamo ancora da vivere, può lasciare spiazzati. È proprio qui che le potenzialità della tecnologia devono essere ricondotte a un alveo umano. «Rispetto a situazioni complesse, l’IA deve essere considerata solo come uno strumento a supporto del medico – o, meglio, dell’équipe medica – che deve continuare a presiedere la valutazione, il ragionamento e il percorso di comunicazione rispetto ai risultati che le tecnologie ci possono dare. Per questo, è fondamentale che si sviluppino sistemi di IA trasparenti, cioè che consentano di ricostruire i passaggi di “ragionamento” fatti dalla macchina per giungere alle sue conclusioni. Solo in questo modo l’elemento umano può fare la differenza rispetto alla tecnologia: lasciare alla macchina il lavoro “faticoso” e più meccanico di analisi, confronto e ricerca dei dati, per consentire al medico di concentrarsi sull’aspetto umano della valutazione e della relazione con il paziente».

È in questa dimensione di “intelligenza umana” che rientra anche la riflessione etica sugli sviluppi che l’IA può avere nell’ambito della cura e il suo impatto sulla vita dei pazienti, dei familiari e delle équipe di cura. «Un ragionamento che in questa fase deve essere aperto e libero da pregiudizi: spesso, infatti, l’etica e la bioetica vengono intesi come elementi chiamati a mettere un freno all’innovazione, mentre non è così. Il compito della bioetica è definire ciò che è ammissibile all’interno di uno spazio potenzialmente infinito quale quello dello sviluppo tecnologico. Ciò che risponde ai bisogni dell’individuo nella sua integrità. L’unità di misura, insomma, resta sempre la persona».